前言

导航是用来引导人、动物或机器人从一个地点到达另一个地点的技术。机器人的导航过程是通过监视周围的环境,控制自身的速度,通过与目标点比对确定位置进而引导自身到达指定地点。按照机器人是否依赖外部设备可分为:自主导航,非自主导航,组合导航。

自主导航作为移动机器人基础能力,一直是机器人科学和人工智能的重大挑战。自主导航技术要求机器人在不依赖外部支持的情况下,仅利用自身携带的测量设备实施确定自身位置、姿态和速度,以此来引导自身完成导航任务。

过去的十几年,基于精确结构化的、几何建模的传统方法产出了许多使用成果。传统的自主导航技术需要利用视觉、惯性、GPS等传感器,建立基于结构化、几何的地图,通过精确计算完成导航任务[1]。然而,这种导航方法缺失学习能力和认知能力,无法自主地应对复杂未知的环境;而且导航与感知、控制模块分离,导致导航信息的决策控制指令无法及时生成,使其无法快速响应环境。但未来机器人控制朝着更深层次的自主性,智能化方向发展,对机器人各类指标有更高要求,所以急需发展一个自主、智能的新型导航系统。

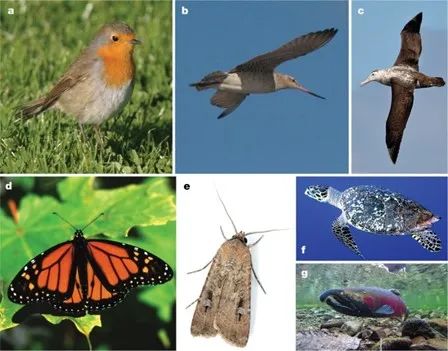

人们发现动物在未知的环境中显示出强大的路径导航的能力。许多小型鸣禽(图1.a)能够在5000km或更长的迁徙距离中以极高的精度进行导航;斑尾塍鹬(图1.b)从阿拉斯加迁徙到新西兰,一次旅途不分昼夜从不停歇;一些海鸟(图1.c)每年飞行超过10万km,返回大洋中的小岛进行繁殖。该现象引起了研究者对动物导航行为的探索

图1 具备长距离迁徙行为的物种[2]

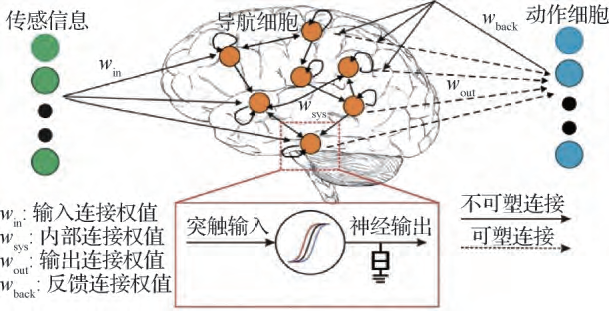

随着脑科学与认知神经科学的不断发展,研究者揭示了昆虫和哺乳动物机器群体大脑导航机理[3]。哺乳动物导航能力以大脑嗅皮层——海马体中大量导航细胞集群放电活动为基础,通过导航细胞形成的神经回路进行导航和定位计算(如图2所示)。

根据目前脑神经科学及生命科学等的相关研究进展,生物体(如小鼠)首先根据身体上的器官感受自己的运动信息,激活头朝向细胞放电,估计自身的方位和前向速度,并传输给网格细胞;然后网格细胞根据这些信息进行积分,建立空间环境中的六边形结构放电特征,建立紧凑的空间尺度地图;然后位置细胞根据身体器官接收到的环境信息联合编码,将整个环境表示为认知地图;当有了导航目标之后然后激活多巴胺神经元,分泌多巴胺建立奖励给动作细胞输出动作指令,最后控制身体向目标移动。

-

- 头朝向细胞:将视觉等信息转化为角速度输入,特定的头朝向细胞放电激活,以此来表示方位。对应传感器测量。

- 网格细胞:对自运动信息积分,对空间进行不同分辨率和方向的度量,形成高效紧凑的空间尺度地图。

- 位置细胞:联合编码整个环境,通过融合外部信息和路径积分信息生成准确、可靠的认知地图。与网格细胞对应定位与建图

- 多巴胺神经元:建立奖励预测误差,融合空间认知信息产生一系列动作指令。对应基于强化学习导航。

图2 哺乳动物大脑导航机理[4]

受哺乳动物大脑导航机理启发,以及AI所能依赖的智能算法、计算能力的发展,一种新型仿生导航技术“类脑导航”得到了较大发展,展现出了自主环境感知、空间认知、面向目标导航一体化智能计算能力,在自主智能机器人系统中具有较大的应用潜力[4]。

一. 类脑导航技术

类脑导航技术是一种通过模仿生物对环境的认知和定位导航能力的新型仿生导航技术。

类脑导航技术使得机器人能够通过构建基于大脑对抽象知识编码和空间位置表示的认知地图,实现陌生环境中不同尺度位置的快速探索和认知,从而高效率,高鲁棒地完成导航任务。因此类脑导航技术的特点为:

-

- 鲁棒性高:利用神经网络模拟生物导航能力,无需对环境精确建模;

- 自主性高:通过学习与环境的交互能力,实时生成导航决策行为;

- 适应性强:能够在从未见过的陌生环境中自主导航;

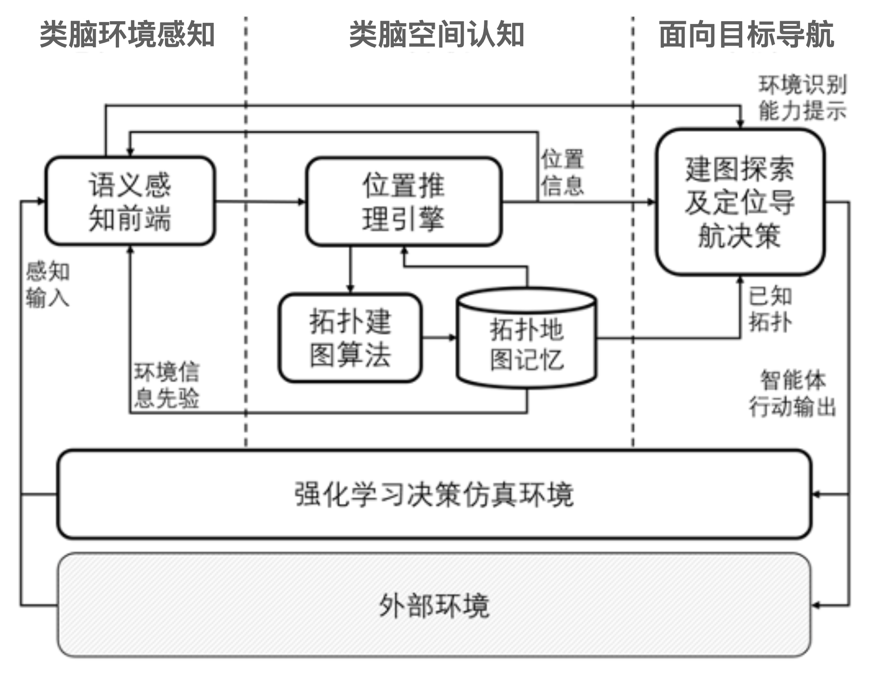

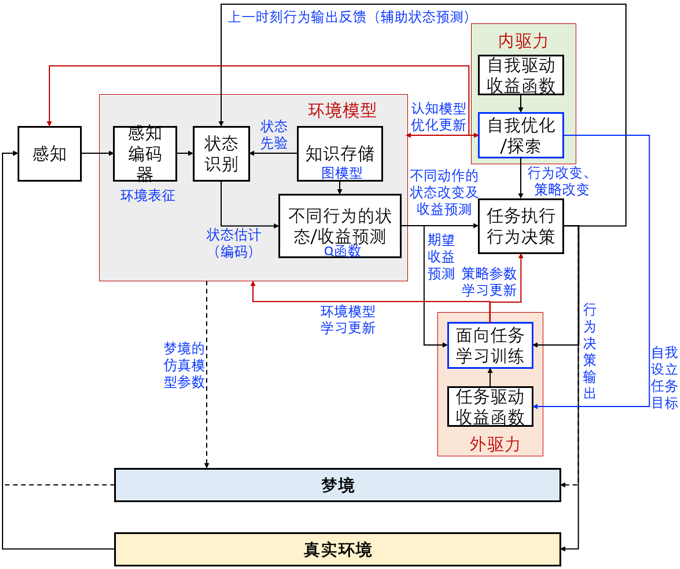

类脑导航技术以自运动内源性、视觉等外源性信息为输入,借鉴动物感知、认知和信息处理机制,采用AI技术实现从原始感知信息输入到导航行为决策的直接输出。根据哺乳动物大脑细胞集群功能区分,将类脑导航系统分为三个部分:类脑环境感知、类脑空间认知、面向目标导航。类脑导航技术流程如图3所示。

图3 类脑导航技术的系统工作流程图

1)类脑环境感知

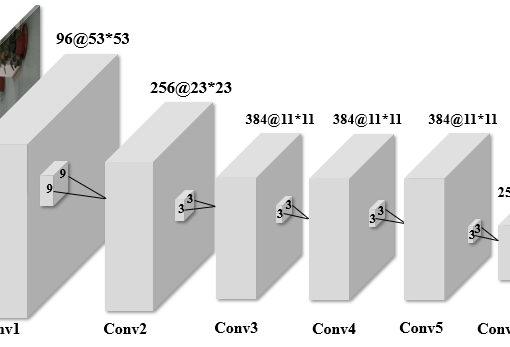

借鉴动物通过视觉、触觉等感知环境的方式以及多模态感官信息的处理机制,采用卷积神经网络等技术,实现对多模态,多维度特征提取以及对自运动和环境信息等解析。

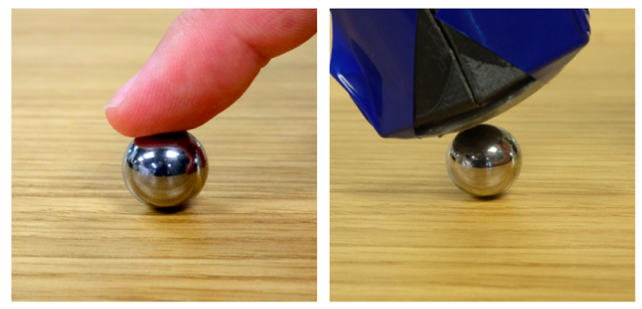

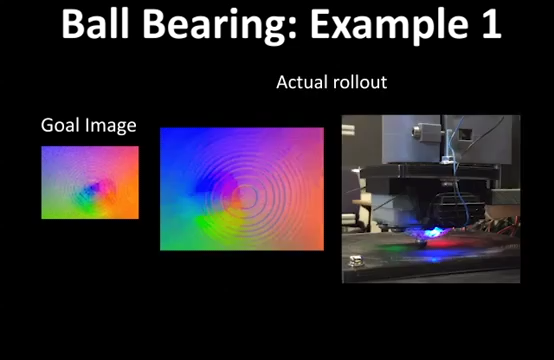

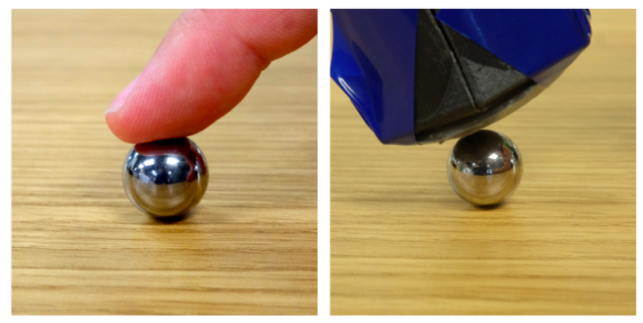

- 基于触摸的深度预测模型

利用图4中的深度学习和触觉传感器构建深度触觉模型,实现了机器人通过触觉信息精确定位物体,进一步融合视觉,触觉,实现了视觉粗略感知和触觉精细感知。

|

|

|

|

|

图4 基于深度学习和触觉传感器构建的深度触觉模型[5]

- 基于分层学习的多感官融合的复杂操作模型

如图5所示,在积木游戏实验场景中,对于机器人的首要任务是区分可移动和不可移动的木块。机器人通过触摸探测木块状态,随着推得越来越深,木块之间摩擦力变大,触觉感受也增大。通过收集记录连续时间内触觉反馈的信息来决策是否可以推动该木块。

图5 基于分层学习的多感官融合的复杂操作模型[6]

c. 基于在线学习算法的感知模型。

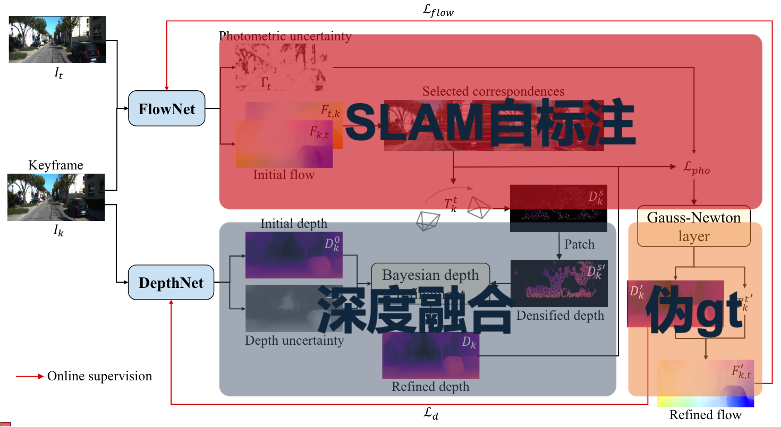

如图6所示,Li等人[7]提出面向陌生环境的,具有在线适应能力的视觉里程计(Visual Odometry, VO)。通过SLAM技术对图片标注特征信息和位姿信息,作为自监督训练时的伪真值,对深度估计网络DepthNet,和光流估计网络FlowNet在线训练,从而实现了从室外环境到室外环境(CityScapeKITTI),室外环境到室内环境(KITTITUM)的定位估计。

图6 基于在线学习算法的感知模型[7]

尽管方法实现了不需要对网络重新训练,通过在线学习的方法使网络适应陌生环境,但该算法设计难度高,容易产生收敛缓慢或过拟合等问题。尽管如此,但在线学习算法仍有较大的研究前景。

2)类脑空间认知

借鉴大脑网格细胞与位置细胞自组织集群放电机制,采用吸引子神经网络等技术,实现位置信息与环境信息的记忆存储以及认知地图的构建。可分为基于吸引子神经网络,基于循环神经网络和基于显示认知地图构建的机制。

- 基于吸引子神经网络模型的RatSLAM

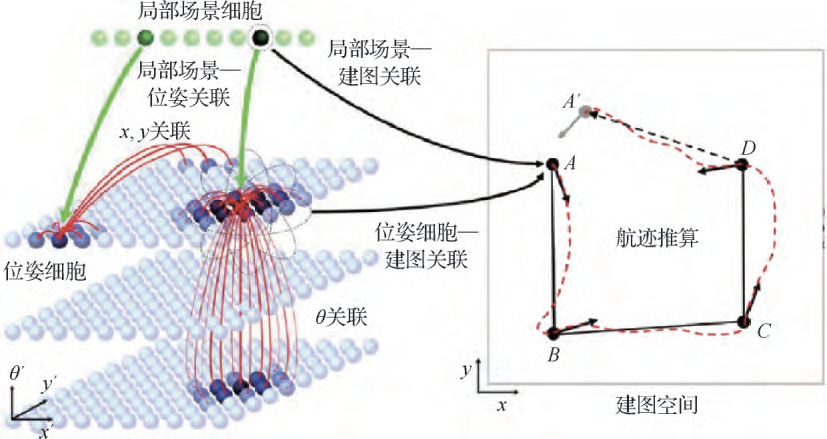

通过吸引子网络模型可以从较弱的视觉输入信息构建大型和复杂区域的认知地图,系统框架如图7所示。

在局部场景细胞中每个单元表示一个不同的视觉环境,当有新的视觉场景出现时,创建一个新的视觉单元格。当机器人再次看到某个视角的视图时,视觉单元格再次被激活,并建立与位姿细胞的关联。位姿细胞是由吸引子网络组成的,通过兴奋性连接建立与附近细胞的联系,这种联系是三维的,在同层级上建立位置上的联系,在不同层级建立姿态角上的联系。

图7 基于吸引子神经网络模型的RatSLAM[8]

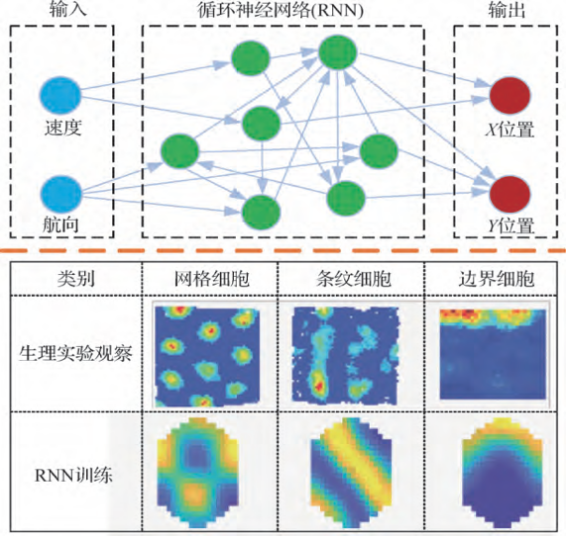

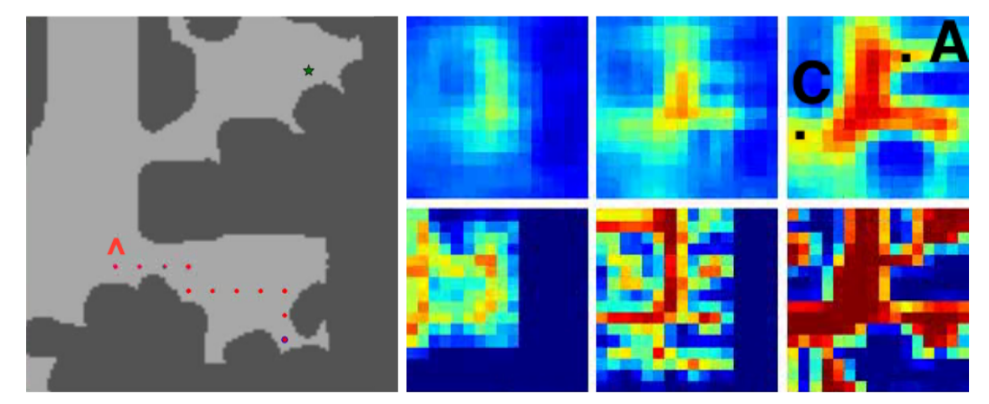

- 基于循环神经网络(RNN)的类脑导航技术

在模拟二维导航任务中,利用RNN中的LSTM网络训练速度和航向信息,仅训练速度和航向信息输出X,Y位置,如图8.a所示。这是为了模拟哺乳动物在不熟悉环境中运动定位所用到的信息。通过RNN隐藏层的可视化发现了RNN节点也呈现出了网格细胞,条纹细胞,边界细胞的放电样式,如图8.b所示。

|

|

|

|

图8.a 基于RNN的类脑导航训练框架[9] |

图8.b RNN隐节点与细胞放电对比[10] |

基于吸引子网络和循环神经网络的记忆推理模型的设计存在容量小,记忆变化快的问题。

c. 基于显示认知地图构建的推理模型

如图9所示,将环境记忆为一张显示栅格地图形式的认知地图,从视觉图像中获取到认知地图后,根据动作的调整来更新。

图9 基于显示认知地图的推理模型[11]

基于显示认知地图构建的推理模型可以把推理过程可视化,使人们更容易理解和解释推理结果;与吸引子网络和循环神经网络相比,认知地图可以存储大量的知识和经验,并在推理过程中高效地搜索和利用这些知识;还可以根据环境变化和实际需求动态调整认知地图的结构和内容。因此基于显示认知地图构建的推理模型具有更高的透明性、稳定性和灵活性。

3)面向目标导航

借鉴动物利用认知地图导航时多巴胺神经元与动作细胞连接激活机制,采用强化学习等技术,实现面向目标位置的路径规划与动作决策。可分为基于监督学习,基于模仿学习和基于深度强化学习。

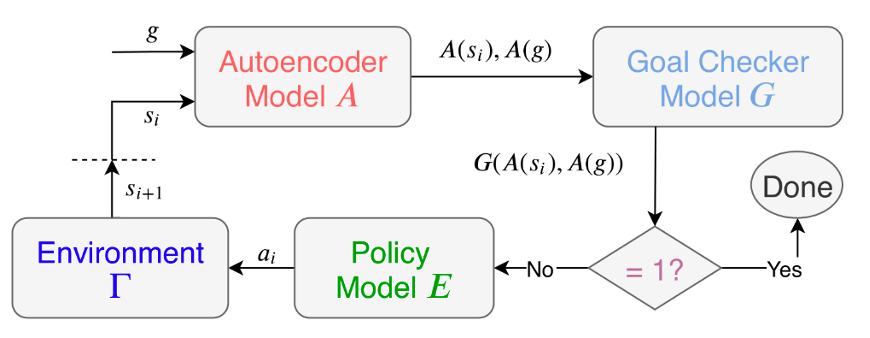

- 基于监督学习机制

基于监督学习机制可分为无监督学习和有监督学习。

基于无监督学习的导航技术的思路是让机器人主动探索,加强特定导航细胞与动作细胞的突出连接强度,最终形成稳定的连接模式。例如,如图10所示,论文[11]采用网格细胞模型对当前位置分别进行多尺度空间编码,通过竞争学习建立当前和目标差异的特定连接。

图10 基于无监督学习的面向目标导航[11]

对于基于有监督学习的导航技术,Watkins-Valls等人[12]提出无需地图,方位,里程计的目标驱动的视觉导航,输入全景图像,仅通过监督学习训练判断导航是否动作,该模型的决策网络,系统流程如图11所示。

图11 基于监督学习机制的决策规划模型[12]

基于监督学习(无监督和有监督)的导航技术尽管能自主、灵活地学习导航决策的行为,但学习效率较低且导航效果有限。

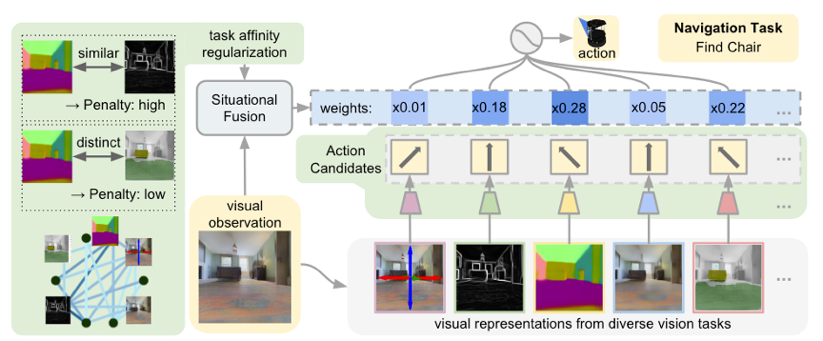

b. 基于模仿学习和注意力机制。

如图12所示,Shen等人[13]利用25个基础视觉任务与训练25个卷积网络,并用模仿学习单独训练他们的动作预测器。并利用注意力机制生成当前环境的采样概率向量,25个动作预测结果融合为1个最终输出的动作。

图12 基于模仿学习和注意力机制决策规划模型[13]

c. 基于深度强化学习的导航

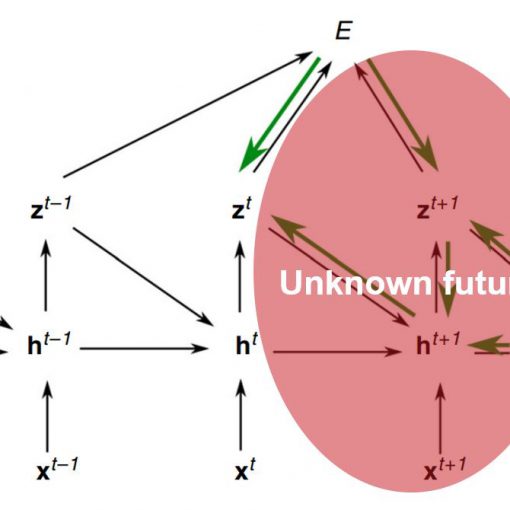

基于强化学习导航思路是通过端到端学习建立最大化策略函数,快速实现原始图像到导航行为决策的输出。例如,如图13所示,在论文[14]中,通过构建双路径深度强化学习导航架构,利用两路RNN分别记忆不同环境导航策略,实现了在没有地图参考,仅给出几个任务奖励的情况下实现导航寻路。

图13 基于深度强化学习的导航[14]

基于深度强化学习的导航,通过设置奖励机制完成导航,这样更接近动物的面向目标导航的思维方式,不像基于监督学习的导航方法那样需要反复去学习。

二. 类脑导航的仿真环境

我们知道对于高度集成多种类型传感器的智能体是十分脆弱的,我们在真实环境中测试类脑导航算法时,可能会由于算法的不稳定导致智能体偏离正常轨迹,甚至发生意外。因此一种可编辑的、高度接近真实场景的仿真环境是发展类脑导航技术的重要工具。

如图18所示,我们提供了6种适用于类脑导航任务的仿真环境,包括可编辑,可定制的小型迷宫DeepMind Lab[15]、室内环境的单个房间渲染合成的AI2-THOR[16]和Ro-boTHOR[17]、多个室内房间的MINOS[18]、涵盖了完整的室内建筑的House3D[19]以及可导入自定义数据的Habitat[20].

图14 适用于类脑导航技术的仿真环境

三. 类脑导航的研究趋势

- 更加智能化的类脑导航系统

现阶段的类脑导航研究主要是从自运动信息、视觉、触觉信息源模拟动物大脑导航,忽略了记忆、推理等其他机制作用。未来将类脑导航与记忆、推理、知识空间或语义空间等更多智能行为产生耦合,主动与环境交互产生更为强大的类脑导航系统。

图15 模拟人脑的梦境行为,建立主动与环境交互的类脑导航系统

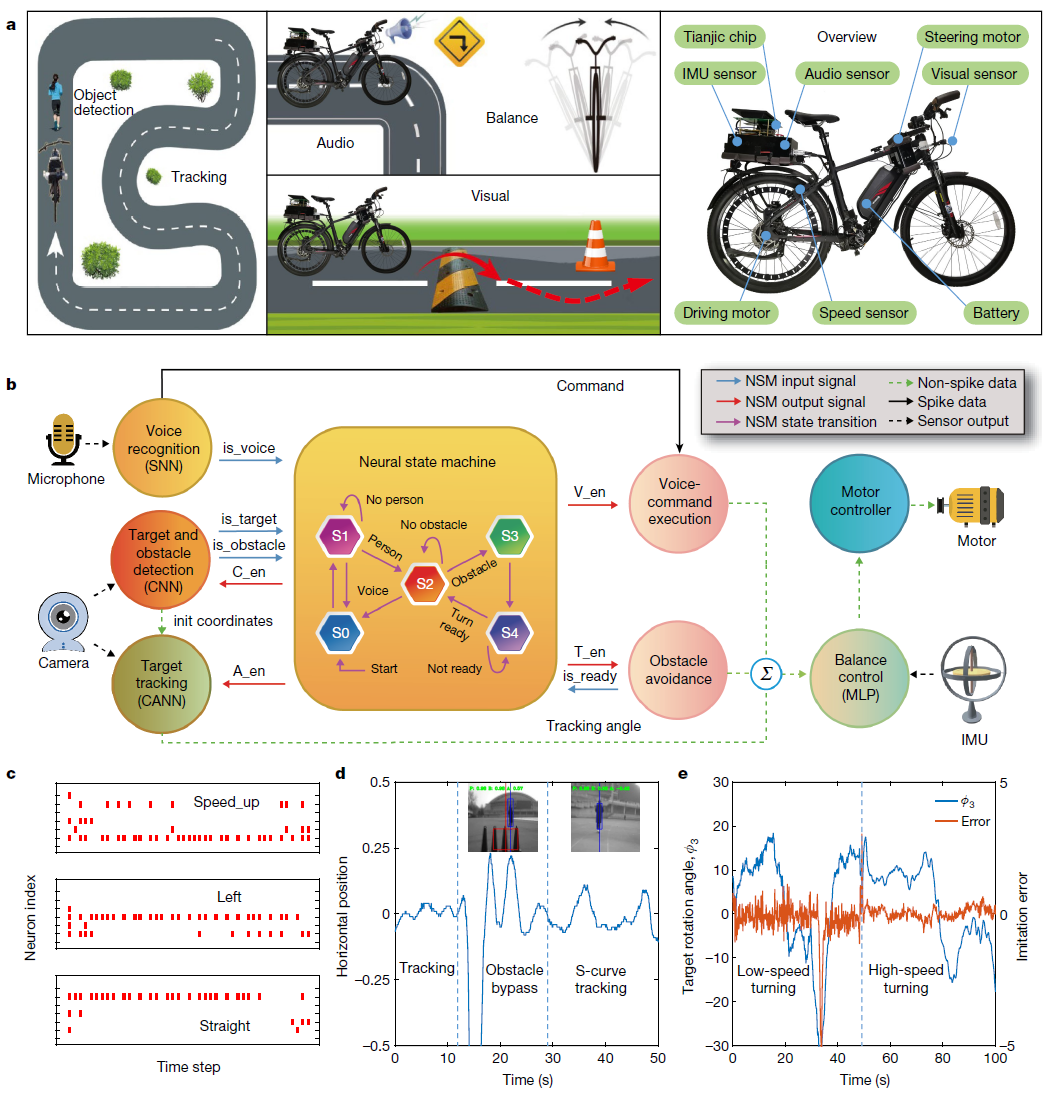

- 类脑神经形态导航系统

当前类脑导航算法实验过程存在模型复杂、计算量大、实时性差、功耗高等弊端。如何借助基于脉冲神经网络SNN的神经形态技术,将软件智能与硬件二者的优势有机结合,从结构层次上模仿大脑,建立更强大的类脑导航系统,实现类脑导航软硬件一体化。

图16 基于天机混合异构类脑芯片的软硬件一体化计算平台[21]

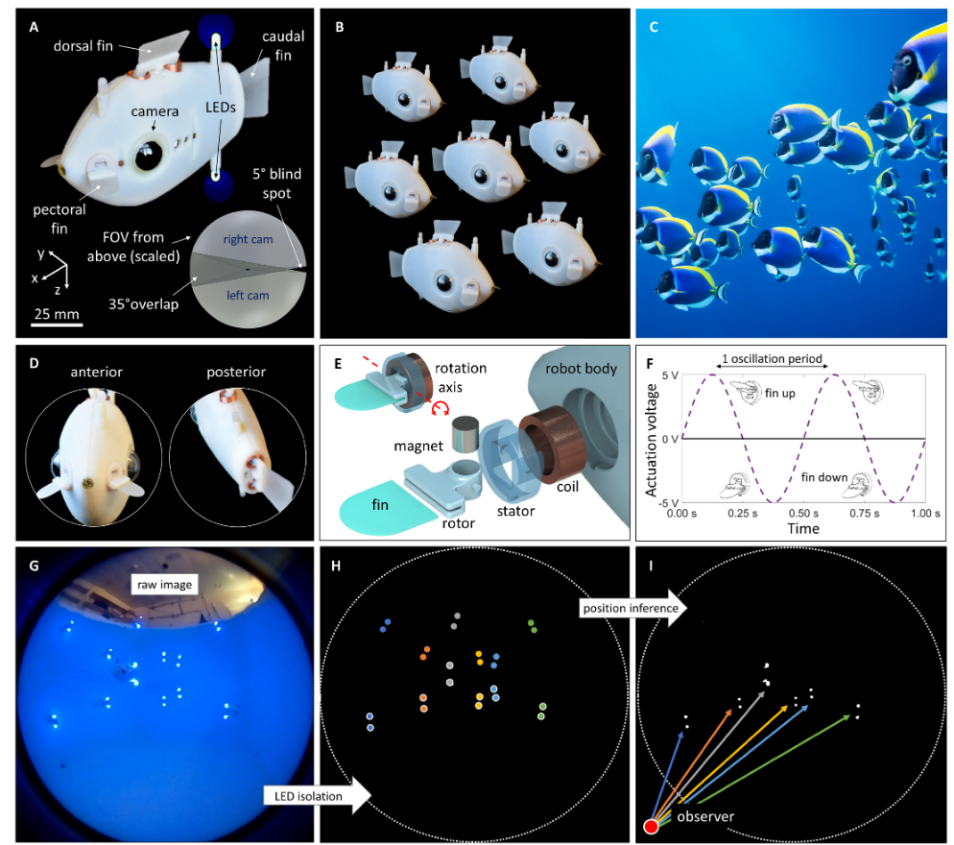

- 类脑群体导航:

自然界中协同工作的蚁群和蜂群,结队巡游的鱼群的自组织行为,为实现类脑导航从个体智能到群体智能导航提供很好的生物模型。

图17 鱼类启发的机器人群中三维水下集体行为的隐性协调[22]

四. 总结

本文以自然界中的动物习以为常的迁徙行为为出发点,介绍动物在自然环境中实现了极远距离、极高的精度的导航行为,动物的该行为引发脑科学研究者的广泛关注。本文以哺乳动物大脑海马体细胞集群放电活动为例,引出了受动物大脑导航机理启发,以及基于AI智能算法和计算能力的,一种新型仿生导航技术——“类脑导航”。类脑导航技术不依赖精确的测量和几何建模,是通过建立对环境的认知进行导航规划。本文还介绍了类脑导航技术的系统框架,包含三个部分:类脑环境感知、类脑空间认知、面向目标导航,并介绍了目前这三个部分的研究进展。另一方面,本文还给出了6种各种类型的适用于类脑导航算法的仿真环境,这是促进类脑导航算法发展的重要工具。最后本文结合近几年Science及其子刊上发表的研究成果,给出类脑导航未来的发展趋势和发展建议。

参考文献

- Guo Chi, Luo Binhan, Li Fei, et al. Review and Verification for Brain-Like Navigation Algorithem[J]. Geomatics and Information Science of Wuhan University, 2021, 46(12): 1819-1831.

- Mouritsen, H. Long-distance navigation and magnetoreception in migratory animals[J]. Nature, 2018, 558(7708): 50-59

- Honkanen A, Adden A, Da Silva Freitas J, et al. The Insect central complex and the neural basis of Navigation Strategies[J]. Journal of Experimental Biology, 2019, 222(SI): 1-5.

- Yang C, Liu J Y, Xiong Z, et al. Brain-inspired Navigation Technology Integrating Perception and Action Decision: A Review and OutLook[J] Acta Aeronautica et Astronautica Sinica, 2020, 41(1): 023280 (in Chinese).

- S. Tian et al., “Manipulation by Feel: Touch-Based Control with Deep Predictive Models,” ICRA, 2019, pp. 818-824.

- N. Fazeli, M. Oller, J. Wu, Z. Wu, J. B. Tenenbaum, and A. Rodriguez, “See, feel, act: Hierarchical learning for complex manipulation skills with multisensory fusion,” Science Robotics, vol. 4, no. 26, p. eaav3123, Jan. 2019.

- S. Li, et al. “Generalizing to the Open World: Deep Visual Odometry with Online Adaptation.” CVPR, 2021

- Banino A, Barry C, Uria B, et al. Vector-based navigation using grid-like representations in artificial agents. Nature. 2018;557(7705)

- C. J. Cueva and X.-X. Wei, “Emergence of grid-like representations by training recurrent neural networks to perform spatial localization.” ICLR,2018

- Edvardsen V. Goal-directed navigation based on path integration and decoding of grid cells in an artificial neural network. Nature Computing, 2016.

- S. Gupta,et al, “Cognitive Mapping and Planning for Visual Navigation.” IJCV, 2020

- D. Watkins-Valls, J. Xu, et al., “Learning Your Way Without Map or Compass: Panoramic Target Driven Visual Navigation.” ICCV, 2020

- B. Shen, D. Xu, Y. Zhu, L. J. Guibas, L. Fei-Fei, et al., “Situational Fusion of Visual Representation for Visual Navigation,” ICRA, 2019

- P. Mirowski et al. Learning to Navigate in Cities Without a Map.NIPS, Jan. 09, 2019

- A customisable 3D platform for agent-based AI research, https://github.com/deepmind/lab

- RoboTHOR is an environment within the AI2-THOR framework, designed to develop embodied AI agents. It consists of a series of scenes in simulation with counterparts in the physical world. https://ai2thor.allenai.org/robothor/

- Matt Deitke, et al. ProcTHOR: Large-Scale Embodied AI Using Procedural Generation, arxiv 2022

- Manolis Savva and Angel X, et al. {MINOS}: Multimodal Indoor Simulator for Navigation in Complex Environments, arxiv, 2017

- Wu, Yi and Wu, Yuxin, et al. Building generalizable agents with a realistic and rich 3D environment, arxiv, 2017

- Andrew Szot and Alex Clegg et al. Habitat 2.0: Training Home Assistants to Rearrange their Habitat, Advances in Neural Information Processing Systems, 2021.

- Pei, J., Deng, L., Song, S. et al. Towards artificial general intelligence with hybrid Tianjic chip architecture. Nature 572, 106–111, 2019

- Florian Berlinger, Melvin Gauci, and Radhika Nagpal. “Implicit coordination for 3D underwater collective behaviors in a fish-inspired robot swarm.” Science Robotics, 6, 50. 2021.