类脑智能应用技术研究中心2019本科生毕设火热招募中!

对毕业论文优先的同学们会给予一定的奖励,请大家仔细研读我中心提供的精彩纷呈的毕设题目,欢迎选择在我们BATC实验室完成学业生涯中至关重要的毕业设计,相信你一定会有满满的收获!

| 课题名称 | 课题简介 | 课题要求 |

| 1.基于视觉辅助的行人航位推算技术研究 | 行人航位推算是通过综合惯性传感器(加速度计、陀螺仪和磁力计)输出信息估算用户位置的定位技术。该技术主要包括行人步态检测、行人步长估计和航向估计三个模块,定位实施不依赖外部部署,定位成本低。但是由于惯性器件累积误差的存在,在长时间工作的情况下存在定位精度下降的问题。基于视觉辅助的行人航位推算技术将深度学习技术中的视觉位置识别和行人航位推算结合,可以很好的解决累积误差的问题,在室内环境下为用户提供可靠的连续位置推算,并最终以AR实景模式显示定位结果。 | 1. 学习深度学习工具,熟悉Python语言,掌握TensorFlow架构; 2. 掌握室内定位和航位推算的原理; 3. 设计优化视觉位置识别网络结构,实现室内位置识别; 4. 融合视觉和航位推算技术,实现高可靠定位算法; 5、完成行人位置AR全景显示demo。 |

| 2.基于多任务共享网络的人脸分析系统 | 人脸分析系统是指通过脸部信息来分析个人属性,研究的主要信息包括局部关键点以及全局性别、年纪等信息。鉴于目前单靠视觉信息准确性不稳定,引入音频信息与视觉信息进行融合来提高人脸属性分析。 | 1.掌握图像数据处理常用方式,以及处理图像的常用算法。 2. 学习深度学习工具,熟悉Python语言,掌握keras、TensorFlow等架构; 3. 了解信息融合的方式,基于视觉与语音信息实现双重识别; 4. 搭建深度分类网络,完成脸部属性识别系统; |

| 3.基于Movidius的行人识别算法开发 | 行人识别是通过视频图像,通过深度学习算法,判断出不同行人的身份的一项技术。此项技术可在智能家居用户定位、事件监测等应用中发挥作用。Movidius是一个可以计算深度学习的芯片,通过该芯片的使用,使得行人识别算法可以便捷地应用。关键研究在于降低行人识别算法复杂度的研究,以及将算法模型加载于芯片上。 | 1.掌握图像数据处理常用方式,以及处理图像的常用算法。 2. 学习深度学习工具,熟悉Python语言,掌握TensorFlow等架构; 3. 掌握Raspberry pi+Movidius的深度学习实现方式; 4. 研究降低行人识别算法复杂度的算法,并在Movidius上进行实现。 |

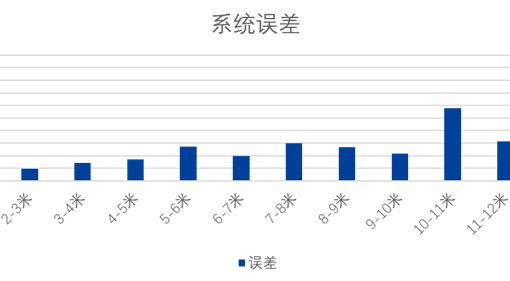

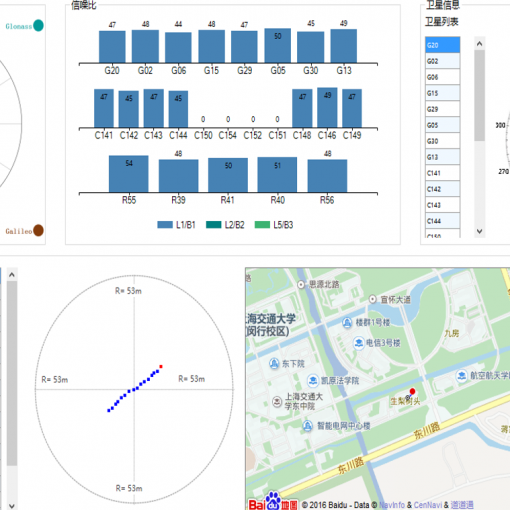

| 4.基于低成本GNSS芯片的星基增强算法研究 | 伴随着北斗三号系统的逐步建成,相应的地基增强和星基增强系统也在论证与实施,其中星基增强将是未来建设的关键技术之一。目前美国的GPS等其他全球或区域卫星导航系统已经有了诸如SBAS等星基增强系统,因此需要通过借鉴SBAS等系统的解码算法来设计北斗自主的星基信号接收模块。而基于低成本GNSS芯片的智能手机的普及则推动了对增强系统的依赖,因此具有潜力巨大的实际价值。 | 1.学习卫星导航基础知识 2.学习Android程序开发 3.调研目前已经存在的星基系统以及相应的数据格式 4.验证星基解码算法的正确性,体现在定位精度的提高等方面 |

| 5.针对TOF相机的深度图像与视频序列压缩算法研究 | TOF相机能够实时获得环境的3D信息,但是深度图和视频序列所需要的存储空间很大,从相机传输到电脑等终端作为数据来源时需要的传输带宽很大,所以深度图像与深度视频的压缩成为了关键的一步。 存储空间和传输带宽成为了深度图像与视频广泛应用的瓶颈,所以压缩算法的研究已经迫在眉睫。未来,深度摄像头会变得和RGB一样普及,应用场景非常广泛,例如远程3维视频会议等,对于深度视频传输的实时性和品质都有较高的要求。但是在刚起步的阶段,深度图几乎无损的压缩和深度图视频序列的压缩比只有3:1和 10:1左右,远远低于现有方法对于RGB图片和视频的压缩比10:1和50:1的压缩效率。事实上,深度图所包含的信息只有空间的3维结构,远少于RGB信息,所以其压缩比还有很大的提升空间。 |

本课题要求研究现有深度图视频压缩的方法,利用TOF相机实际的数据进行测试,分析其处理效果,改进其中一种算法,使其适应于ToF深度图序列的高质量压缩的需求。 |

| 6.基于深度图像的复杂场景人体骨架识别算法研究 | 使用3D深度图像进行人体部位检测与动作识别是目前人工智能领域一个热门的研究方向,相较于传统RGB相机,3D深度相机直接获得距离信息,而不需要使用传统双目测量方法获取深度,具有更高环境适应性和更低的计算复杂度。 然而目前使用3D深度相机在人员大尺度运动、复杂场景、人员遮挡等情况下获取精确的人体关节坐标仍然存在困难,主要是由于深度相机只能拍摄特定视角的点云数据,无法多角度对人体运动状态进行准确估计,此外3D相机本身存在噪声和数据跳变的问题导致数据连续性较差。因此为了精确识别计算人体关节位置,需要结合基于深度探针特征的决策树算法与PCA拟合、运动滤波等一系列机器学习算法,通过数据训练,开发一个基于3D深度点云信息的实时人体关节定位系统,用于精确计算大尺度运动场景下的人体关节位置并进行动作识别,并实现多人遮挡场景下的多人关节定位与骨架检测。 |

本课题要求研究现有几种关节定位方法,进行比较,并实现支持大尺度运动等复杂场景下的人员关节定位算法,满足定位精度要求,分析其处理效果,优化参数,利用Python或C/C++语言实现算法。 |

| 7.基于深度视觉的物体三维结构重建及3mf文件生成 | TOF相机能够实时获得拍摄物体的3D信息,经过滤波、拼接等处理后,能够得到重建物体的点云模型,结合灰度图或者RGB图以及已经生成的点云模型完成表面重建和纹理贴图,并生成3D打印所需要的3mf文件。 首先,三维重建应用的场景非常广泛,如医学投影、增强现实、3D打印等领域,算法框架是通用的,但是针对不同领域有不同的具体要求。本次毕业设计主要针对3D打印所需的数据,重建物体的结构较简单,需要了解深度图点云之间的转换关系,学习点云匹配方法,学习表面重建的方法以及纹理贴图算法;在重建出表面之后,将重建的结果存储为3mf的数据格式,需要了解3mf的存储格式要求。 |

本课题要求研究现有三维重建的算法以及3mf文件格式要求,利用TOF相机实际的数据进行表面重建并将重建结果存储为3mf文件。 |

| 8.基于深度图像的手势行为实时识别算法研究 | 作为最自然的交互语言之一,手势交互已经逐渐在应用领域展现潜力,手势行为识别算法研究是当前学界和业界的热门方向,尤其是基于深度图的3D手势行为识别算法。 目前的手势行为识别算法的精度依赖于人工特征的选择,算法的适用场景也比较受限,算法适应性有待改善。同时,目前的算法测试范围局限于公开数据集,实际可用性暂未可知。所以,基于实际TOF相机的手势行为识别算法研究势在必行。识别算法可以借鉴目前人体行为识别的思路,分成两步。一方面需要研究基于深度图的手势模型建模,从深度图中恢复出3D模型,得到手部各关节的位置。另外,还需要研究基于手部关节点位置的手势动作识别,在已知的关节位置基础上识别动作。 |

本课题要求完成基于TOF相机的手势行为识别,改进现有的手势建模算法,能够在实际场景中识别出常见的手势。 |

| 9.基于深度图像的动态物体实时三维测量 | TOF相机能够直接得到物体表面的距离摄像头的深度,通过转换为点云可以精确地获取物体在三维空间中的尺寸信息。利用TOF相机的这个特点,我们可以对包裹进行三维尺寸测量。 传统物流业通过人工对包裹进行三维尺寸测量,费时费力而且误差难以避免,通过TOF相机可以快速测量包裹的三维尺寸。但实际应用中会遇到很多问题,例如外界光照会给TOF相机的测量结果带来噪声,x、y轴测量结果会受相机镜头畸变影响,运动包裹会造成深度模糊。研究内容包含三个部分,首先在遮光条件下实现对静止包裹的精确三维测量,然后在有外界光照干扰的条件下下实现三维测量,最后模拟实际工业应用场景,在有光照干扰,且包裹在传输带上相对TOF相机运动的情况下下实现三维测量。 |

本课题要求研究基于TOF相机的三维测量技术,可以通过采集深度视频流实时对包裹进行测量,涉及到图像处理,滤波,畸变矫正,三维建模等知识,具有学术研究价值。同时三维测量应用广泛,具有工业应用价值。 |

| 10.基于rgbd相机的3D点云语义分割算法研究 | 传统的rgb相机可以获取环境的多通道2D信息,但是无法获取深度值。增加深度相机后,rgbd相机能够直接获取环境的2.5D信息,从而提供了更丰富和直接的环境信息,在三维重建等领域有诱人的应用前景。 为了充分利用rgbd图片信息,提取关键信息,我们需要智能的算法。目前常用的语义分割算法可以实现像素级别的分类效果,精确提取图片中的物体,提供了很好的信息提取效果。然而,现阶段对rgbd图片的算法研究尚浅,已有的语义分割算法多数适用于rgb图片或3D点云,因此两者结合的研究方向还有很大的探索空间。 |

本课题要求研究现有语义分割算法,将其应用到rgbd图片,测试分析其处理效果并改进其中一种算法,使其在rgbd数据集上达到较好的语义分割效果。 |

| 11.基于语义分割的回环检测方法研究 | 机器人自主导航是机器人领域里面的一个核心问题,而自主导航中的一个关键问题是在已有建好地图情况下机器人的鲁棒回环检测(机器人识别出曾经来过这个地方),一个鲁棒的回环检测模块将会极大的提升机器人自主导航的能力。

传统的回环检测方法将图像中的所有特征描述作为图像的索引,在已经建好的数据库中搜索和被搜索图像最相似的图像。由于数据库同时存贮图像和相应地理位置信息,因此可以被用于检测曾经到达过的地方(回环检测)。传统的回环检测准确率较低,需要改进,同时最近基于神经网络的语义视觉里程计方法(如VSO)被大量提出,因此需要一种基于语义的回环检测方法作为新的后处理模块。 |

本课题要求使用已有神经网络分割出的语义信息,替代传统的特征点描述子,进而改进传统算法,使其适用于语义信息的输入。本课题需要在室内场景和学校场景,采集若干图像,用于训练,最后在已有机器人平台上进行回环检测实验。 |

| 12.基于视觉与识别的机器人定位系统 | 在现代广泛应用的机器人系统中(如无人车、无人机等),机器人的“眼睛”,由摄像机构成的视觉定位传感器是机器人实现其功能最主要的一部分。在这其中,视觉里程计方法(VO)通过感知不同时间里视野内场景信息的差异推导出机器人当前的位置,解决了为机器人感知“我是不是在动”以及“我在怎么动”的问题。 然而在实际的复杂应用场景中,由于无法保证相机视野内的物体均处于静止状态,因此会带来位置估算上面的误差。为了解决该问题,本课题拟利用可以对环境进行语义分割的神经网络算法对视频图像进行预处理,挑选并筛除可能存在运动及非固定的物体,以降低运动物体对机器人位置估算的干扰,提高定位精度。 |

本课题要求在已有视觉里程计算法基础上利用成熟分割算法实现对图像的预处理,并在已有机器人上实践该算法,提升机器人的定位精度。 |

| 13.基于SLAM的室内机器人巡查系统 | 越来越多的机器人将会出现在未来社会的各行各业上为人类服务。在一些办公室楼宇内使用机器人自动进行安全巡查可大大减少人类重复枯燥劳动。自动巡查的核心功能是定位和导航。 simultaneous localization and mapping(SLAM)定位是机器人定位中重要、高效的手段,与UWB等室内定位方法相比,其不需要在环境中部署额外设备的特点大大降低了机器人定位的成本和使用环境的灵活性,因此本课题将选取SLAM作为机器人定位手段。在已知地图中导航还会遇到的问题是环境中可能出现原来没有的障碍物,机器人需要实时识别并绕开障碍物,从而继续执行巡查任务。 本课题将会实现让地面小车机器人在SLAM建立好的地图里执行指定线路巡查任务。本课题需要研究的问题是:如何识别障碍物并控制机器人绕过障碍物继续执行巡查任务。课题难点如下:如何快速识别指定路径上存在的障碍物,实时规划并执行躲避路线。 |

1. 能认真对待课题内容,每天需要到实验室报道,每周汇报工作进展; 2. 能熟练使用c++、python,有在ubuntu系统编程经验; 3. 能熟练使用机器人操作系统(ROS)更优; |

| 14.基于蓝牙的高精度室内定位系统 | 室内定位技术在室内导航、商场按需营销、智慧城市、安全监控管理、防走失等方面有广泛的应用需求。由于蓝牙在普通移动智能终端中的广泛应用,基于蓝牙的定位技术具有良好的普适性、易用性和推广前景。本课题设计拟采用蓝牙多天线测角技术实现复杂室内环境下的高精度定位, 通过结合多天线测角技术和多径抑制技术实现远优于现有蓝牙定位技术的精度。 | 本课题要求研究现适用于多径环境的多天线测角技术,利用实测蓝牙数据进行定位验证。 |

| 15.基于CEVA DSP的图像特征提取及算法优化 | 图像特征提取,即在图像中寻找具有丰富几何特征的点、线或面等局部区域,并以特定方式对区域进行编码。该方法被广泛用于各类机器视觉应用,如物体识别、场景匹配、地图重建等。相比精度更高的卷积神经网络方法,传统的特征提取算法在执行效率上具有明显优势,因此在非高精度要求的应用中,传统算法依然有重要的使用价值。另一方面,前端信息预处理逐渐呈现出边缘计算的形态,在功耗和计算能力十分有限的条件下又对算法有较高的实时性需求。 为此,本科题拟在CEVA-XM4 DSP上,基于ORB算法实现底层图像特征提取,并根据DSP的特定指令集和专用计算单元对算法进行灵活调度与优化。 该项目可以培养学生的论文阅读 |

信号处理知识;计算机组成原理;C/C++编程; 完整实现ORB算法,并加入关键点分布均衡机制,在CEVA—XM4 DSP上可以达到20fps处理速度。 |

| 16.FUN处理器集成开发环境设计 | 在单线程性能瓶颈的今天,函数式编程语言在并行计算方面愈发体现出其天然的优势。本实验室以λ演算为基础,设计了一种新的函数式可编程处理器架构”fun”,涵盖了指令集、编译器与操作系统。为了推进该项目进入实用阶段,现需构建相应的软件开发工具和基础运行库。 本课题将根据项目需求设计一个集成开发环境(IDE),包括对编译器、操作系统的支持,能够模拟整个硬件平台,包括外部设备如加速度计、陀螺仪、GPS和摄像头等。 本课题以开源的软件和工具为框架,指导学生完成IDE设计,并且通过若干示例程序学习编译器、FPGA和函数式编程知识。 |

C/C++编程;嵌入式系统知识; 完成IDE代码编辑、调试、信息打印等基础功能,并负责一到两个外设模拟功能 |

联系人:黄佳怡

联系电话:138 1694 6365

联系邮件:huangjiayi@sjtu.edu.cn